Autor/in: Tony Franzky

Für diesen Text benötigst du etwa 4 Minuten

Was sind Deepfakes?

Das Wort “Deepfake” ist eine Wortschöpfung aus Deeplearning und Fake. Und meint das Manipulieren, Fälschen oder künstliche Erschaffen von multimedialem Inhalten mittels Künstlicher Intelligenz (KI) bzw. KI Algorithmen. Das Konzept des Fälschens ist dabei kein neues: Seien es Urkunden, Artefakte, Kunstwerke, Handschriften, Münzen. Neu daran ist eher die verwendete Technik. Während man sich früher noch allerlei handwerklicher Techniken bedienen musste, oder wenigstens einige Stunden vor Photoshop verbrachte um sein Gesicht auf einem anderen Körper zu montieren wird heutzutage Technologie benutzt, die sehr schnell und sehr einfach höchst ansehnliche Ergebnisse liefert. Den fälschbaren Inhalten sind dabei keine Grenzen gesetzt. Seien es nun Videos, Fotos, Sprachaufnahmen oder anderes.

Wie entwickelten sich Deepfakes?

Der technische Grundstein für Deepfakes wurde zwar bereits in den 90er Jahren gelegt, doch erst mit der massiven Steigerung von Rechenleistung und Datenverarbeitungskapazität wurde “Deepfaking” auch durch die breitere Masse nutzbar. 2016 etwa stellte Adobe VoCo vor, eine Sprachbearbeitungssoftware die als Proof of Concept offiziell nicht in die Adobe CC wandern wird, aber zeitweise als das “Photoshop für Audioaufnahmen” gehandelt wurde.

Eines der bekanntesten Phänomene im nichtkommerziellen Bereich ist ist die visuelle Manipulation diverser Filmszenen in denen Nicolas Cage mittels “FaceSwapping” (dem Austausch von Gesichtern) in diverse Filme und Scenen “hineingearbeitet” wurde.

Wie so oft bei der Verbreitung neuer Technologie ist auch hier die erotische und pornografische[2] Verwendung sehr entwicklungstreibend. So gibt es mittlerweile unzählige einschlägige (Nackt-)Filme in denen Personen zu sehen sind, die nur mittels KI hinein manipuliert wurden.

Ein weiteres Beispiel hierfür war die App “DeepNude”. Eine Anwendung versprach eine Art “X-Ray” App zu sein und mittels KI Technologie die Kleidung von Personen auf Fotos zu “entfernen”. Mal unabhängig davon, dass – sexistischer Weise – dieses System nur auf Frauenkörper antrainiert wurde gab es über 500.000 Downloadanfragen, eine Hitzige Debatte und hier und hier. Aufgrund dessen entfernten die Nutzer diese App wieder und gestanden in einem Twitterpost zu, dass die Welt wohl noch nicht bereit dafür ist. Da das Internet jedoch nicht vergisst sind auch heutzutage noch unzählige (zum Teil mit Schadsoftware infizierte) Kopien und Klone der Software unterwegs.

Und wie geht ein Deepfake?

Nun ja, seit einiger Zeit wünschte ich mir für die Arbeit ja eine Popcornmaschine. Vielleicht noch einen Slushymaker und eine Zuckerwattemaschine. Außerdem eine Gehaltserhöhung, ein verglastes Eckbüro und einen Dienstwagen. Da man solche Dinge leider noch nicht so einfach selbst programmieren und dann aus dem 3D Drucker rauslassen kann, muss ich also – sehr altmodisch – meine durchaus gerechtfertigten Wünsche meinem Chef vortragen. Seine Antwort war… eher nein.

Aber das ist kein Problem. Wie wir alle wissen kann man mit “Vektor und NLP” eine ganze Menge machen. Vortrainierte Modelle benötigen nur eine kleine Sprachprobe von 5 Sekunden um damit bereits achtbare Ergebnisse zu liefern.

Eines davon beschreibt Corentin Jemine in seiner Masterthesis und ist bereits fertig auf GitHub[3] verfügbar.

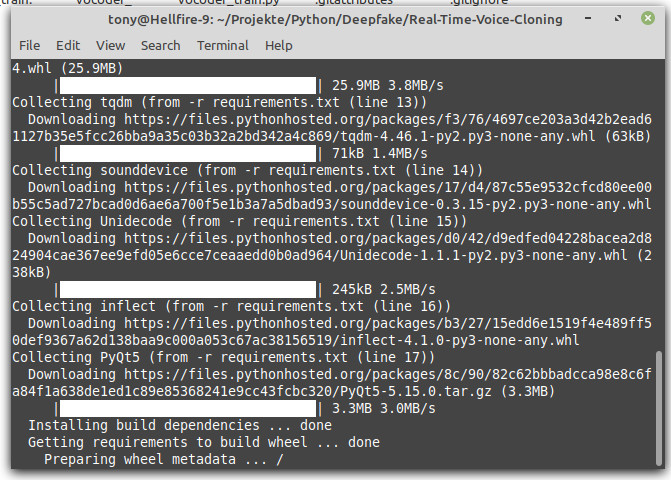

Die Installation ist denkbar einfach und aufgrund einer beigefügten “requirements.txt” braucht es nur wenige Minuten, um auch alle nötigen Pythonbibliotheken zu installieren. (Wenn man sowas händisch für Bibliotheken wie Tensorflow machen müsste, kann es durchaus ein nervenaufreibendes Unternehmen sein.)

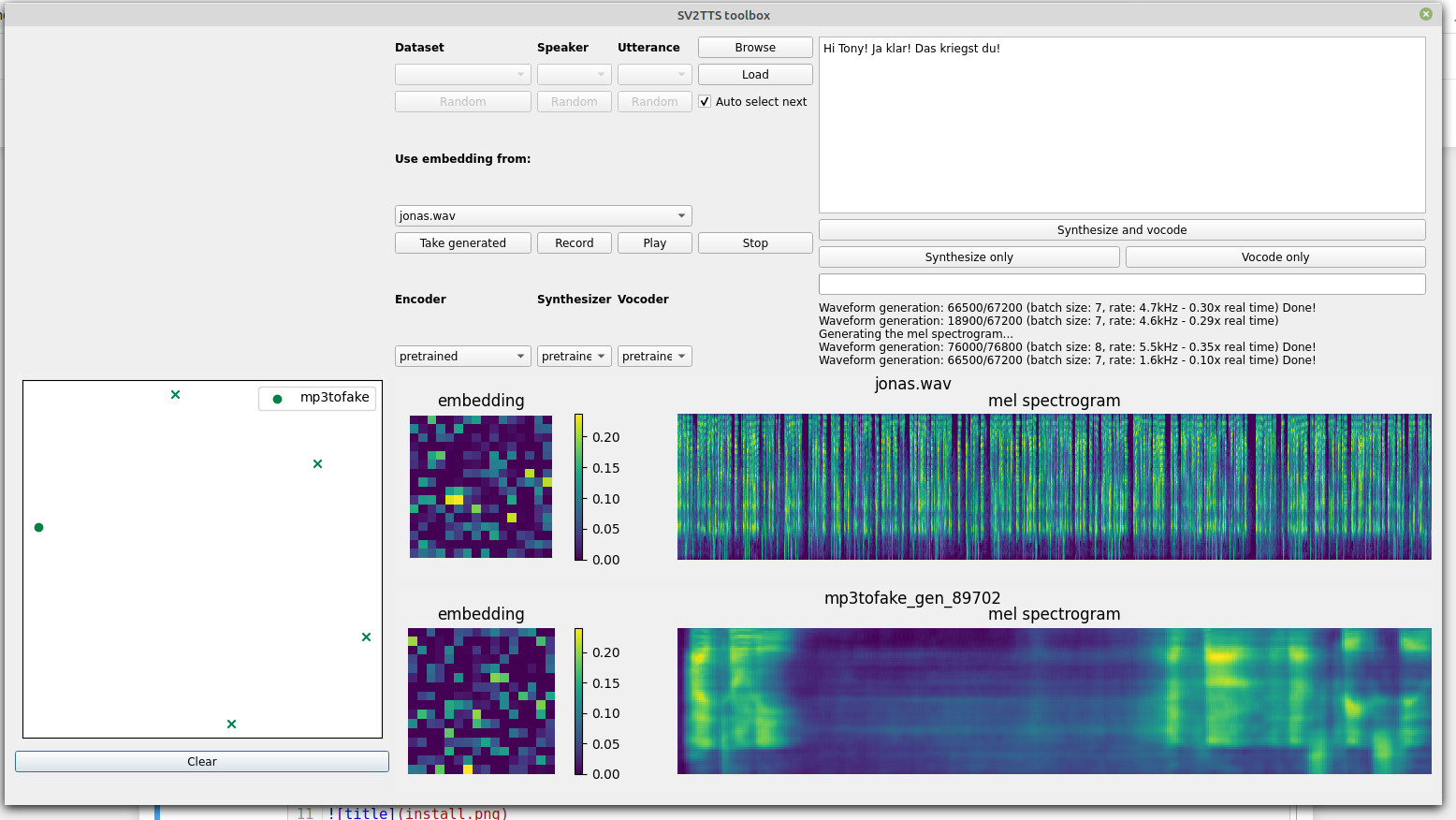

Nachdem alles installiert ist benötigt man (übrigens ganz ohne Programmierkenntnisse) nur noch eine Sprachprobe und kann direkt in der Kommandozeile oder in einer grafischen Oberfläche anfangen seinen eigenen Deepfakes zu generieren.

Jetzt nur noch die Absage von meinem Chef hineingeworfen und daraus eine Zusage bekommen und voilá!

Die Originalnachricht

Die Fake Nachricht

Und der Unterschied? Naja, man hört es schon, sodass ich etwas tricksen musste. Das liegt vornehmlich daran, dass man hier ein vortrainiertes englisches Modell hat. Wenn ich es etwas besser haben möchte muss ich das natürlich nachtrainieren. Das erfordert zwar etwas mehr Skills, ist aber eigentlich kein Problem. Grundlage dafür wären zunächst einige Sprachsamples in Deutsch, die annotiert sind. Grundlage für das Modell von Corentine war übrigens Librispeech. Das sind gute 1TB Festplattenspeicher und ne dicke Grafikkarte die man fürs trainieren braucht. Und wenn man das selbst machen will? Ein Audiosample kriegt man schnell zusammen, wenn man sich ein paar Hörbücher samt Buch als Transkript besorgt. Mit etwas Schweiß und Arbeit kann man das als Trainingsgrundlage umbauen und dann deutsche Sprachausgabe realisieren.

Und wofür das alles?

Mittlerweile gibt es bereits einige Tools die Voiceclonig auch kommerzialisiert betreiben. Etwa das aus dem obigen GitProjekt entstandene resemble.ai, Lyrebird oder Cereproc.

Und na klar ist das schön, wenn man im Autonavigationssystem die Stimme seines Freundes hat oder man einfach ein Hörbuch mit der Stimme von Morgan Freeman generieren kann. Auch lassen sich mittels dieser Technologie angewendet etwa auf Filme großartige Ergebnisse erzielen. Etwa wenn man statt CGI Modelle in Filmen auch lebensechte(re) Gesichtsersetzungen durchführen kann.

Dennoch lässt diese Technologie auch sehr viel Raum für missbräuchliche Benutzung. Erst im September 2019 etwa gelang es Betrügern mittels künstlich generierter Stimme eines CEOs eine Summe von umgerechnet 220.000 Euro zu erbeuten indem sie einen Telefonanruf fingierten.

Wenn man zudem bedenkt, dass es mittlerweile auch Kreditkarten mit Sprachauthentifizierung gibt, bekommen Deepfakes und insbesondere Voicecloning nochmal eine andere Dimension. Auch weil viele kleinere Unternehmen heutzutage noch nicht über ausreichende Validierungsmöglichkeiten von Sprach- und Audiodaten verfügen. Das gleiche gilt für (Echtzeit-)Fälschungen von Videos etwa mittels DeepFaceLab

Schluss und Anmerkungen

Nun, aus meinen Wünschen ist leider (noch) nichts geworden. Auch weil sich – wie ein Kollege richtig anmerkte – für mein gläsernes Eckbüro alle anderen in den Serverraum quetschen müssten. Das Thema bleibt dennoch spannend, weil es zeigt, dass gerade in der Zunkunft Themen wie Informationskompetenz, Technikfolgenabschätzung und verantwortungsvoller Umgang mit modernen Technologien viel stärker in der Fokus rücken werden.

—

[1]:Eine sehr gute bibliografische Sammlung zum Thema (Kunst-)Fälschungen findet sich bei der Uni Bibliothek Heidelberg, die im Rahmen des DFG-Projekts “arthistoricum.net – Fachinformationsdienst Kunst” gehostet und betrieben wird.

[2]:Für weitere Informationen: https://scholarship.law.duke.edu

[3]: GitHub ist einer der führenden Software-Repositiorium Dienste zur Versionsverwaltung für Software-Projekte.